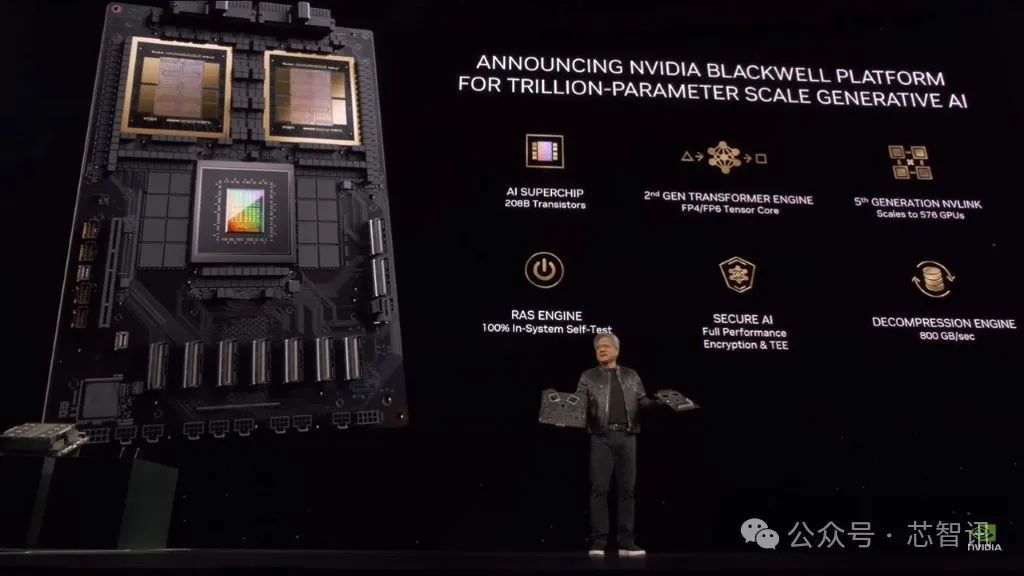

当地技艺3月18日,东谈主工智能(AI)芯片龙头厂商英伟达在好意思国加州圣何塞召开了GTC2024大会,认真发布了面向下一代数据中心和东谈主工智能讹诈的“核弹”——基于Blackwell架构的B200 GPU,将在筹谋才调上终了弘远的代际飞跃,预测将在本年晚些时候认真出货。同期,英伟达还带来了Grace Blackwell GB200超等芯片等。

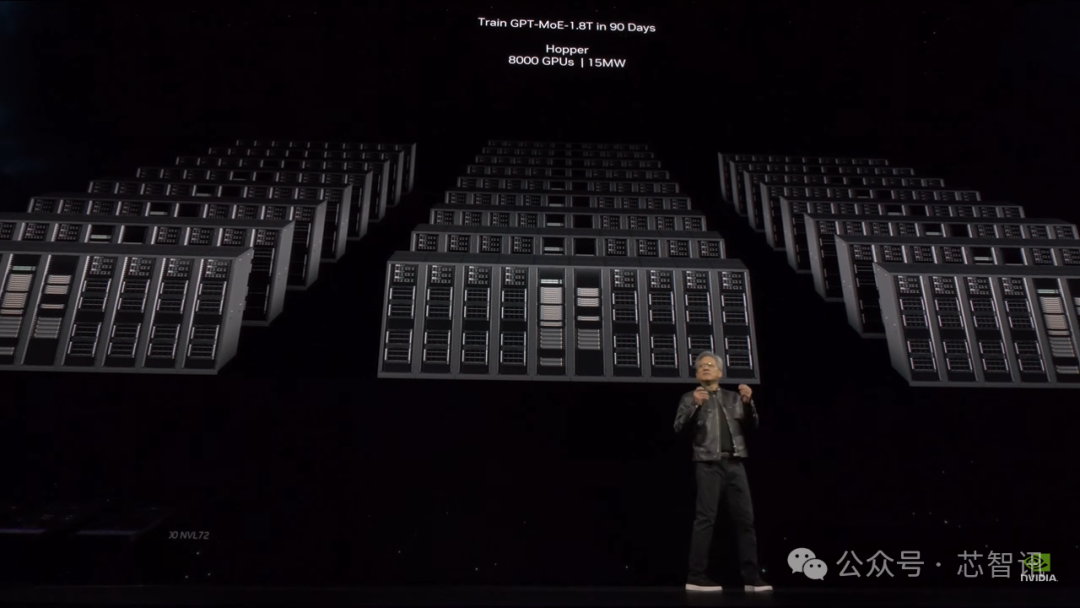

英伟达首创东谈主兼CEO黄仁勋,英伟达现在按照每隔2年的更新频率,升级一次GPU构架,进一步大幅栽培AI芯片的性能。两年前推出的Hopper构架GPU天然依然相称出色了,但咱们需要更强劲的GPU。

B200:2080亿个晶体管,FP4算力高达 40 petaflops

英伟达于2022年发布了礼聘Hopper构架的H100 GPU之后,运行引颈了人人AI阛阓的风潮。这次推出的礼聘Blackwell构架的B200性能将愈加强劲,更擅所长理AI联系的任务。而Blackwell构架则是以数学家David Harold Blackwell的名字定名。

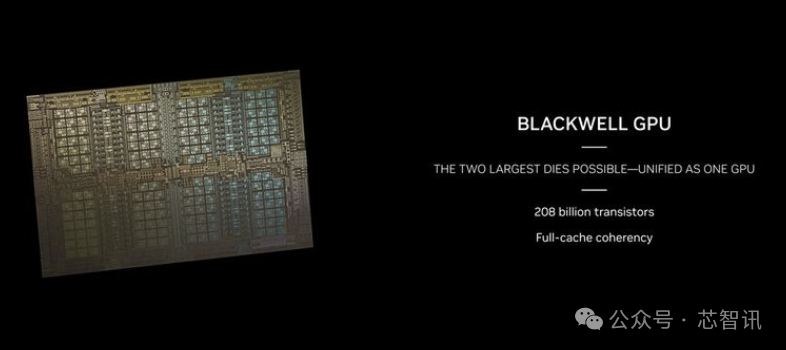

据先容,B200 GPU基于台积电的N4P制程工艺(这是上一代Hopper H100和Ada Lovelace架构GPU使用的N4工艺的改良版块),晶体管数目达到了2080亿个,是H100/H200的800亿个晶体管两倍多。这也使得B200的东谈主工智能性能达到了20 petaflops。

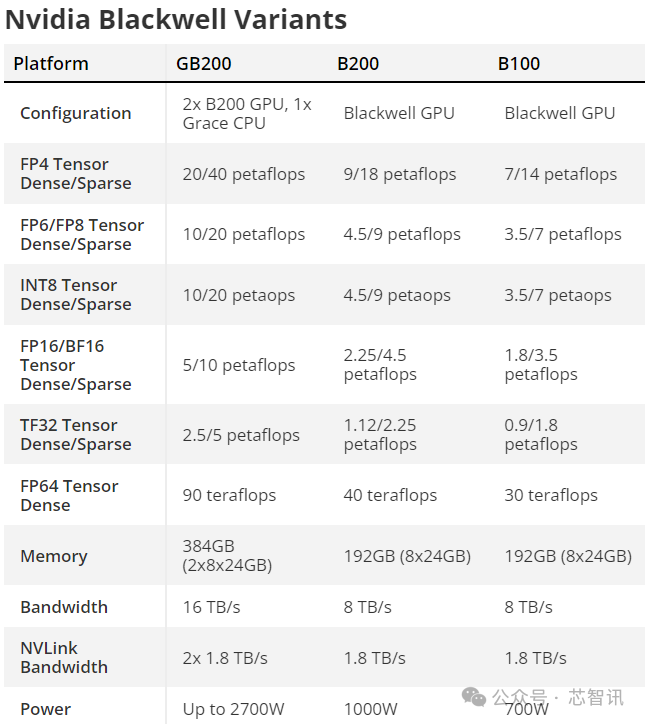

黄仁勋默示,Blackwell构架B200 GPU的AI运算性能在FP8及新的FP6上齐可达20 petaflops,是前一代Hopper构架的H100运算性能8 petaflops的2.5倍。在新的FP4格式上更可达到40 petaflops,是前一代Hopper构架GPU运算性能8 petaflops的5倍。具体取决于多样Blackwell构架GPU诞生的內存容量和频宽建树,使命运算实施力的本色性能可能会更高。黄仁勋强调,而有了这些稀少的处理才调,将使东谈主工机灵企业省略考研更大、更复杂的模子。

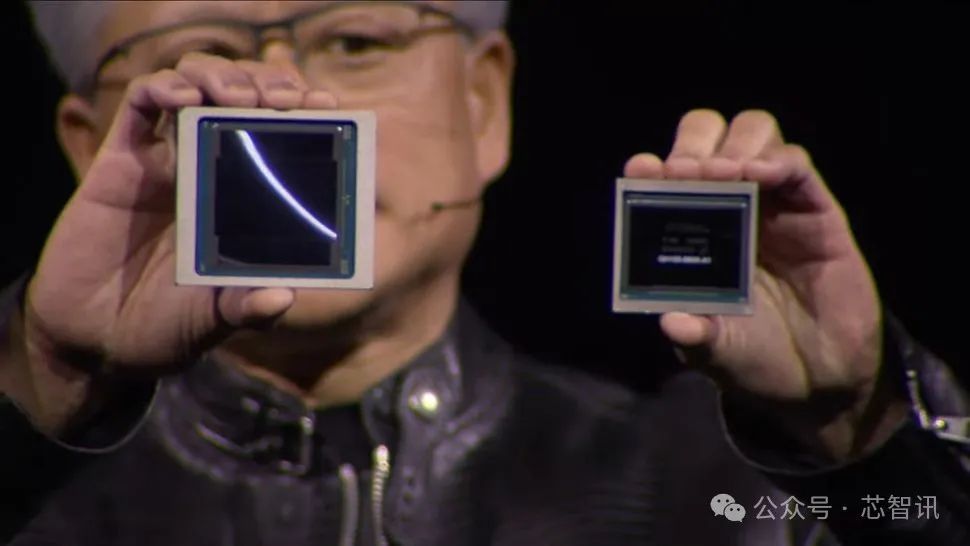

但是,需要指出的是,B200并不是传统意旨上的单一GPU。相悖,它由两个纷乱耦合的GPU芯片构成。尽管凭据英伟达的说法,它们如实不错看成一个谐和的CUDA GPU。这两个芯片通过10 TB/s的NV-HBI(英伟达高带宽接口)合资合资,以确保它们省略看成一个十足一致的芯片浅薄使命。

同期,对于东谈主工智能筹谋来说,HBM容量亦然极为关节。AMD MI300X之是以被平凡眷注,除了其性能大幅栽培除外,其所配备的容量高达192GB HBM(高带宽内存)也口角常关节,比拟英伟达H100 SXM芯片的80GB高了一倍多。而为了弥补HBM容量的不及,天然英伟达也推出了配备141GB HBM的H200,但是仍大幅逾期于AMD MI300X。而这次英伟达推出的B200则配备了相同的192GB HBM3e内存,可提供8 TB/s的带宽,弥补了这一薄弱模范。

天然英伟达尚未提供对于B200着实的芯片尺寸,从曝光的像片来看,B200将使用两个全掩模尺寸的芯片,每个管芯周围有四个HMB3e堆栈,每个堆栈为24GB,每个堆栈在1024 bit接口上具有1TB/s的带宽。

需要指出的是,H100礼聘的是6个HBM3堆栈,每个堆栈16GB(H200将其加多到6个24GB),这意味着H100管芯中有相称一部分特意用于六个HBM内存戒指器。而B200通过将每个芯片里面的HBM内存戒指器接口减少到四个,并将两个芯片合资在沿途,这么不错相应地减少HBM内存戒指器接口所需的管芯面积,不错将更多的晶体管用于筹谋。

救助全新FP4/FP6格式

基于Blackwell架构的B200通过一种新的FP4数字格式达到了这个数字,其辩说量是Hopper H100的FP8格式的两倍。因此,要是咱们将B200与H100坚抓使用FP8算力来比较,B200仅提供了比H100多2.5倍的表面FP8筹谋(具有稀少性),其中很大一部分原因来自于B200领有两个筹谋芯片。对于H100和B200齐救助的大大齐的数字格式,B200最终在表面上每芯片算力栽培了1.25倍。

再次回到4NP工艺节点在密度方面枯竭大限制改良的问题上。移除两个HBM3接口,并制作一个稍大的芯片可能意味着B200在芯片级的筹谋密度上以致不会显耀更高。天然,两个芯片之间的NV-HBI接口也会占用一些管芯面积。

英伟达还提供了B200的其他数字格式的原始筹谋值,并讹诈了频频的缩放因子。因此,FP8的辩说量是FP4辩说量的一半(10 petaflops级),FP16/BF16的辩说量是5 petaflops级的一半,TF32的救助是FP16的一半(2.5 petaflops级)——整个这些齐具有稀少性,因此密集操作的速度是这些速度的一半。相同,在整个情况下,算力不错达到单个H100的2.5倍。

那么FP64的算力又怎样呢?H100被评定为每GPU可提供60万亿次的密集FP64筹谋。要是B200具有与其他格式肖似的缩放比例,则每个双芯片GPU将具有150万亿次浮点运算。但是,本色上,B200的FP64性能有所下跌,每个GPU约为45万亿次浮点运算。但这也需要一些明白,因为GB200超等芯片将是关节的构建块之一。它有两个B200 GPU,不错进行90万亿次的密集FP64筹谋,与H100比拟,其他成分可能会提高经典模拟的原始辩说量。

另外,就使用FP4而言,英伟达有一个新的第二代Transformer Engine,它将匡助用户自动将模子退换为允洽的格式,神秘顾客新闻以达到最大性能。除了救助FP4,Blackwell还将救助一种新的FP6格式,这是一种介于FP4枯竭必要精度但也不需要FP8的情况下的处治决策。不管效果的精度怎样,英伟达齐将此类用例归类为“大众搀和”(MoE)模子。

最强AI芯片GB200

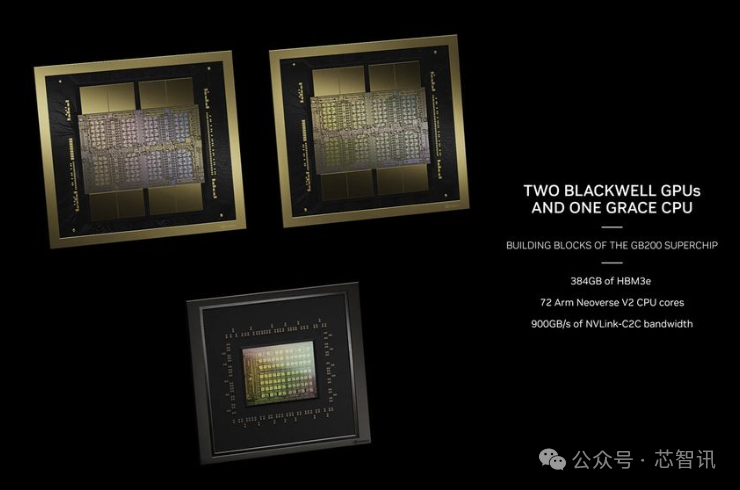

英伟达还推出了GB200超等芯片,它基于两个B200 GPU,外加一个Grace CPU,也便是说,GB200超等芯片的表面算力将会达到40 petaflops,整个这个词超等芯片的可建树TDP高达2700W。

黄仁勋也进一步指出,包含了两个Blackwell GPU和一个礼聘Arm构架的Grace CPU的B200,其推理模子性能比H100栽培30倍,资本和能耗降至了原本的1/25。

除了GB200超等芯片除外,英伟达还带来了面向干事器的处治决策HGX B200,它基于在单个干事器节点中使用八个B200 GPU和一个x86 CPU(可能是两个CPU)。这些TDP建树为每个B200 GPU 1000W,GPU可提供高达18 petaflops的FP4辩说量,因此从纸面上看,它比GB200中的GPU慢10%。

此外,还有HGX B100,它与HGX B200的基本架构交流,有一个x86 CPU和八个B100 GPU,仅仅它被瞎想为与现存的HGX H100基础设施兼容,并允许最快速地部署Blackwell GPU。因此,每个GPU的TDP被为止为700W,与H100交流,辩说量降至每个GPU 14 petaflops的FP4。

值得矜重的是,在这三款芯片当中,HBM3e的每个GPU的带宽似乎齐是8 TB/s。因此,只邀功率,以及GPU中枢时钟,也许还有中枢数上会有不同。但是,英伟达尚未披露任何Blackwell GPU中有若干CUDA内核或流式多处理器的细节。

第五代NVLink和NVLink Switch 7.2T

东谈主工智能和HPC使命负载的一大为止成分是不同节点之间通讯的多节点互连带宽。跟着GPU数目的加多,通讯成为一个严重的瓶颈,可能占所用资源和技艺的60%。在推出B200的同期,英伟达还推出其第五代NVLink和NVLink Switch 7.2T。

新的NVLink芯片具有1.8 TB/s的全对全双向带宽,救助576 GPU NVLink域。它亦然基于台积电N4P节点上制造的,领有500亿个晶体管。该芯片还救助芯片上蚁合筹谋中的3.6万亿次Sharp v4,这有助于高效处理更大的模子。

上一代NVSwitch救助高达100 GB/s的HDR InfiniBand带宽,是一个弘远飞跃。而与H100多节点互连比拟,全新的NVSwitch提供了18X的加快。这将大大提高万亿参数模子东谈主工智能蚁合的可膨胀性。

与此联系的是,每个Blackwell GPU齐配备了18个第五代NVLink合资。这是H100衔接数目的18倍。每条链路提供50 GB/s的双向带宽,或每条链路提供100 GB/s的带宽。

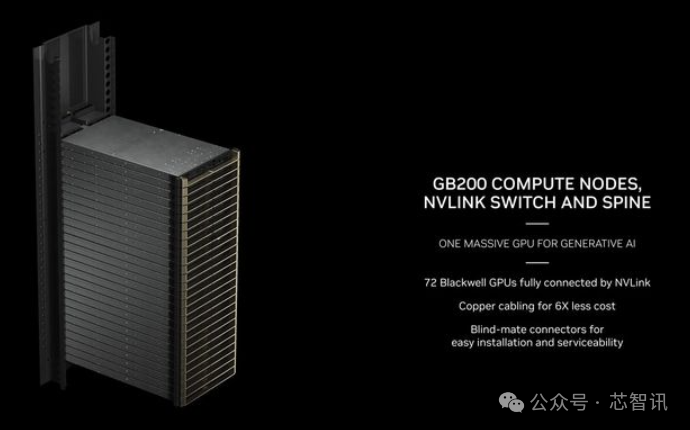

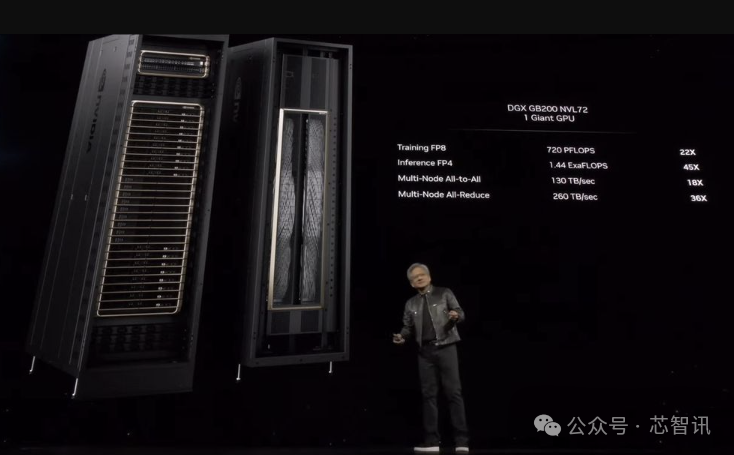

GB200 NVL72干事器

英伟达还针对有大型需求的企业提供干事器制品,提供齐备的干事器处治决策,举例GB200 NVL72干事器,提供了36个CPU和72个Blackwell构架GPU,并完善提供一体水冷散热决策,可终了共计720 petaflops的AI考研性能或1,440 petaflops的推感性能。它里面使用电缆长度累计接近2英里,共有5,000条寂寥电缆。

具体来说,GB200 NVL72 基本上是一个齐备的机架式处治决策,有18个1U干事器,每个干事器齐有两个GB200超等芯片。但是,在GB200超等芯片的构成方面,与上一代比拟存在一些互异。

曝光图片和规格标明,两个B200 GPU与一个Grace CPU匹配,而GH100使用了一个较小的处治决策,将一个GraceCPU与一个H100 GPU放在沿途。最终效果是,GB200超等芯片筹谋托盘将具有两个Grace CPU和四个B200 GPU,具有80 petaflops的FP4 AI推理和40 PB的FP8 AI考研性能。这些是液冷1U干事器,它们占据了机架中典型的42个单位空间的很大一部分。

除了GB200超等芯片筹谋托盘,GB200 NVL72还将配备NVLink交换机托盘。这些亦然1U液冷托盘,每个托盘有两个NVLink交换机,每个机架有九个这么的托盘。每个托盘提供14.4 TB/s的总带宽,加向前边提到的Sharp v4筹谋。

GB200 NVL72所有有36个Grace CPU和72个Blackwell GPU,FP8运算量为720 PB,FP4运算量为1440 PB。有130 TB/s的多节点带宽,英伟达默示NVL72不错处理多达27万亿个AI LLM参数模子。

现在,亚马逊的AWS已筹谋采购由2万片GB200芯片组建的干事器集群,不错部署27万亿个参数的模子。除了亚马逊的AWS除外,DELL、Alphabet、Meta、微软、OpenAI、Oracle和TESLA成为Blackwell系列的礼聘者之一。